AMD Instinct MI350シリーズとその先:AIとHPCの未来を加速する

2025-07-14更新

概要(At a Glance)

- AMD Instinct™ MI350シリーズを発表:前世代比でAI演算性能 最大4倍、推論性能 最大35倍の向上を実現

- ROCm 7.0をリリース:ROCm 6.0と比較して、推論性能4倍以上・学習性能3倍以上の向上

- 新たな開発者向けクラウド「Developer Cloud」**を公開:開発者がAMD Instinct GPUおよびROCmにスムーズにアクセスし、AIイノベーションを加速可能に

- 次世代AIラックインフラ「Helios」**をプレビュー:MI400 GPU、EPYC “Venice” CPU、Pensando “Vulcano” NICを統合し、前例のないAI演算密度とスケーラビリティを提供

AIの進化は止まらない——そして、AMDも同じです

AMDは、ただ業界に追随するのではなく、新たな基準を打ち立てています。

お客様が求めているのは、現実的かつスケーラブルなAIソリューション。

それに応えるのが、AMD Instinct MI350シリーズです。

最先端の性能、巨大なメモリ帯域、そして柔軟なオープンインフラを備えたMI350シリーズは、

さまざまな業界のイノベーターにより速く、より賢くスケールし、「次の未来」を築く力を提供します。

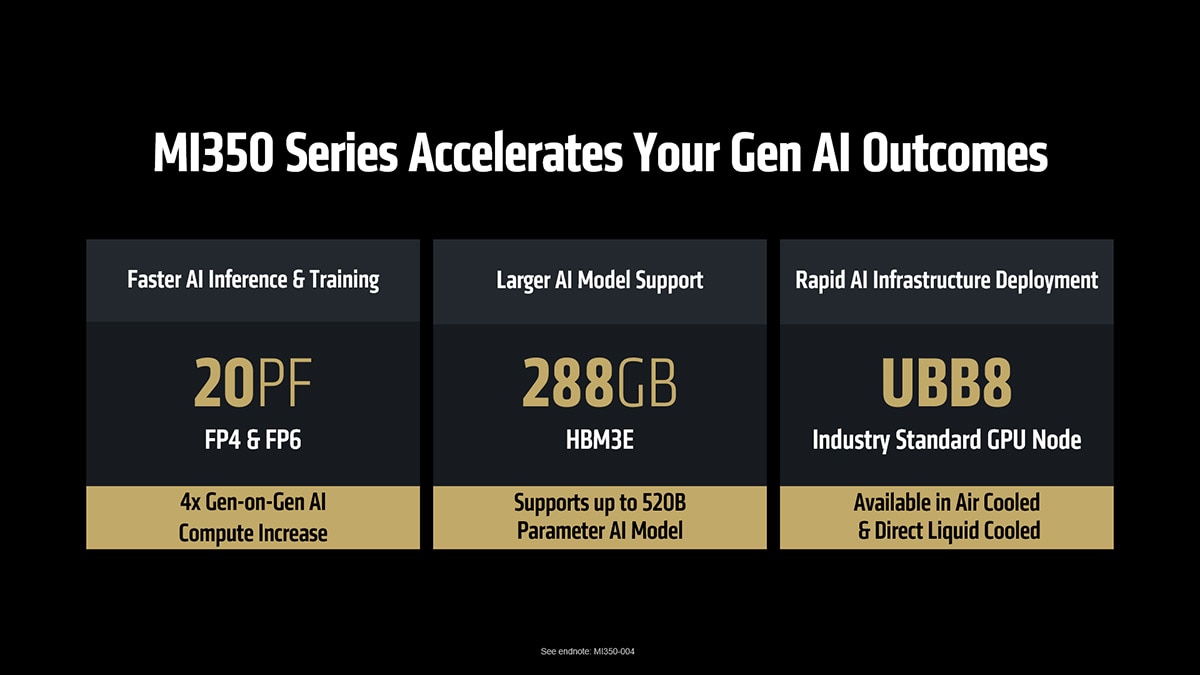

次世代のAIワークロードを支える

AMD CDNA™ 4アーキテクチャを採用したAMD Instinct MI350X / MI355X GPUは、

現代のAIインフラに求められる高性能に特化して設計された製品です。

MI350シリーズは、前世代比で

- AI演算性能 最大4倍

- 推論性能 最大35倍

という飛躍的な進化を実現し、業界横断でAIの革新を後押しします。

また、MicronおよびSamsung製の288GB HBM3Eメモリと

最大8TB/sの帯域幅を備え、推論・学習の両面で卓越したスループット性能を発揮します。

図1:MI350シリーズは、より高速なAI推論を実現し、大規模モデルへの対応とAIイノベーションの加速を可能にします¹。

柔軟な空冷および直接液冷の構成に対応したInstinct MI350シリーズは、シームレスな導入を実現するよう最適化されています。

- 空冷ラックでは最大64基のGPU

- 直接液冷ラックでは最大128基のGPUを搭載可能

- FP4/FP6性能で最大2.6エクサFLOPSを実現

この構成により、AI導入までの時間を短縮し、業界標準に準拠したインフラでコスト削減を可能にします。

重要な数字:Instinct MI350シリーズの仕様

| SPECIFICATIONS (PEAK THEORETICAL) |

AMD INSTINCT™ MI350X GPU | AMD INSTINCT™ MI350X PLATFORM | AMD INSTINCT™ MI355X GPU | AMD INSTINCT™ MI355X PLATFORM |

| GPUs | Instinct MI350X OAM | 8 x Instinct MI350X OAM | Instinct MI355X OAM | 8 x Instinct MI355X OAM |

| GPU Architecture | CDNA 4 | CDNA 4 | CDNA 4 | CDNA 4 |

| Dedicated Memory Size | 288 GB HBM3E | 2.3 TB HBM3E | 288 GB HBM3E | 2.3 TB HBM3E |

| Memory Bandwidth | 8 TB/s | 8 TB/s per OAM | 8 TB/s | 8 TB/s per OAM |

| FP64 Performance | 72 TFLOPs | 577 TFLOPs | 78.6 TFLOPS | 628.8 TFLOPs |

| FP16 Performance* | 4.6 PFLOPS | 36.8 PFLOPS | 5 PFLOPS | 40.2 PFLOPS |

| FP8 Performance* | 9.2 PFLOPs | 73.82 PFLOPs | 10.1 PFLOPs | 80.5 PFLOPs |

| FP6 Performance* | 18.45 PFLOPS | 147.6 PFLOPS | 20.1 PFLOPS | 161 PFLOPS |

| FP4 Performance* | 18.45 PFLOPS | 147.6 PFLOPS | 20.1 PFLOPS | 161 PFLOPS |

*構造的スパース性(structured sparsity)有効時の性能

図2:AMD Instinct MI355X GPUは、卓越したメモリ容量と帯域幅を備え、圧倒的なパフォーマンスを発揮します。

*FP64を除く全てのマトリックスコア性能は構造的スパース性(sparsity)を考慮した数値です。

図3:AMD Instinct MI350シリーズプラットフォームは、要求の厳しいワークロードに対応したシームレスな展開を可能にするよう設計されています。

エコシステムの勢いと展開準備

MI350シリーズは、大手クラウドサービスプロバイダー(主要なハイパースケーラーや次世代のネオクラウドを含む)を通じて幅広く提供され、顧客にクラウド上でのAIスケーリングに柔軟な選択肢をもたらします。

同時に、Dell、HPE、Supermicroなどの主要OEMはMI350シリーズを自社プラットフォームに統合し、強力なオンプレミスおよびハイブリッドAIインフラを提供しています。AMD Instinct MI350シリーズGPUの採用を支援する主要OEMやクラウドサービスプロバイダーについてはこちらをご覧ください。

ROCm™ 7:AIアクセラレーションのためのオープンソフトウェアエンジン

AIは驚異的な速度で進化しており、AMDのROCmはオープンでスケーラブル、開発者に焦点を当てたプラットフォームとして、そのイノベーションを誰もが活用できるようにします。

過去1年でROCmは急速に成熟し、推論性能のリーダーシップ、学習機能の拡充、オープンソースコミュニティとの連携強化を実現してきました。

ROCmは現在、世界最大規模のAIプラットフォームのいくつかを支え、LLaMAやDeepSeekなどの主要モデルを初日からサポートし、次期ROCm 7リリースでは推論性能が3.5倍以上向上します。

頻繁なアップデート、高度なデータ型(FP4など)、新アルゴリズム(FAv3)により、ROCmは次世代AI性能を実現しつつ、vLLMやSGLangといったオープンソースフレームワークの発展を閉鎖的な代替よりも速く推進しています。

研究段階から実運用企業展開へ移行するAI採用に伴い、ROCmも進化を続けています。

ROCm Enterprise AIはフルスタックのMLOpsプラットフォームを提供し、微調整、コンプライアンス、展開、統合のためのターンキー(即利用可能)ツールにより、安全かつスケーラブルなAI運用を可能にします。

180万以上のHugging Faceモデルがすぐに利用可能で、業界ベンチマークも整い、ROCmは追いつくどころか、オープンAI革命を牽引しています。

開発者は私たちのすべての中心です。

より良い標準搭載ツール、リアルタイムCIダッシュボード、充実した資料、活発なコミュニティにより、ROCm上での開発がこれまで以上に容易になっています。

ハッカソンや高性能カーネルコンテストなどの盛り上がりも加速中。

本日、新たにAMD Developer Cloudを開始し、開発者にROCmとAMD GPUへの即時かつ障壁のないアクセスを提供し、イノベーションを加速させます。

大規模言語モデルの最適化から推論プラットフォームの拡張まで、ROCm 7は開発者が実験から本番運用へ迅速に移行するためのツールを提供します。

ROCm 7の詳細な利点については、当社のブログをご覧ください。

次の展望:AMD Instinct MI400シリーズと「Helios」AIラックのプレビュー

AMDの革新へのコミットメントはMI350シリーズで止まりません。

2026年に登場予定の次世代AMD Instinct MI400シリーズは、性能面で大幅な世代交代を実現します。

MI400シリーズは、大規模トレーニングおよび分散推論に対応するフルラックレベルのソリューションを可能にします。主な性能革新は以下の通りです:

- 最大432GBのHBM4メモリ

- 19.6TB/sのメモリ帯域幅

- FP4性能40PF、FP8性能20PF

- 300GB/sのスケールアウト帯域幅

2026年登場予定の「Helios」AIラックインフラは、AMD EPYC “Venice” CPU、Instinct MI400シリーズGPU、Pensando “Vulcano” AI NIC、ROCmソフトウェアを一体化した統合ソリューションとして設計されています。

Heliosは最大72基のMI400シリーズGPUを緊密に結合し、260テラバイト/秒のスケールアップ帯域幅を備え、Ultra Accelerator Linkをサポートします。

「Helios」AIラックソリューションの詳細はブログをご覧ください。

未来のAIを支える基盤作り

最新のAMD CDNA 4アーキテクチャに基づき、オープンかつ最適化されたROCmソフトウェアスタックに支えられたInstinct MI350XおよびMI355X GPUは、強力で将来に対応可能なAIインフラの構築を可能にします。

ROCmは、オープンソースの高速性、開発者ファーストの設計、画期的な性能でAIイノベーションの扉を開きます。

推論から学習、フルスタックの展開まで、未来のAIに向けてスケールできるプラットフォームです。

ROCm 7とAMD Developer Cloudを通じて、私たちはまだ始まったばかりです。

次世代のMI400シリーズとAMD「Helios」ラックアーキテクチャに向けて、Instinct MI4000シリーズは新たな基準を設定し、組織がより速く動き、賢くスケールし、生成AIおよび高性能コンピューティングの可能性を最大限に引き出すことを支援します。